コンテキスト・エンジニアリングとは?プロンプト・エンジニアリングとの決定的な違いを解説

ChatGPTの登場以降、「プロンプトエンジニアリング」という言葉は、AIに関わる全ての人々にとって必須のスキルとなりました。

いかに巧みな指示を出し、大規模言語モデル(LLM)から望ましい回答を引き出すか。その技術は、AI活用の第一歩として今も重要です。

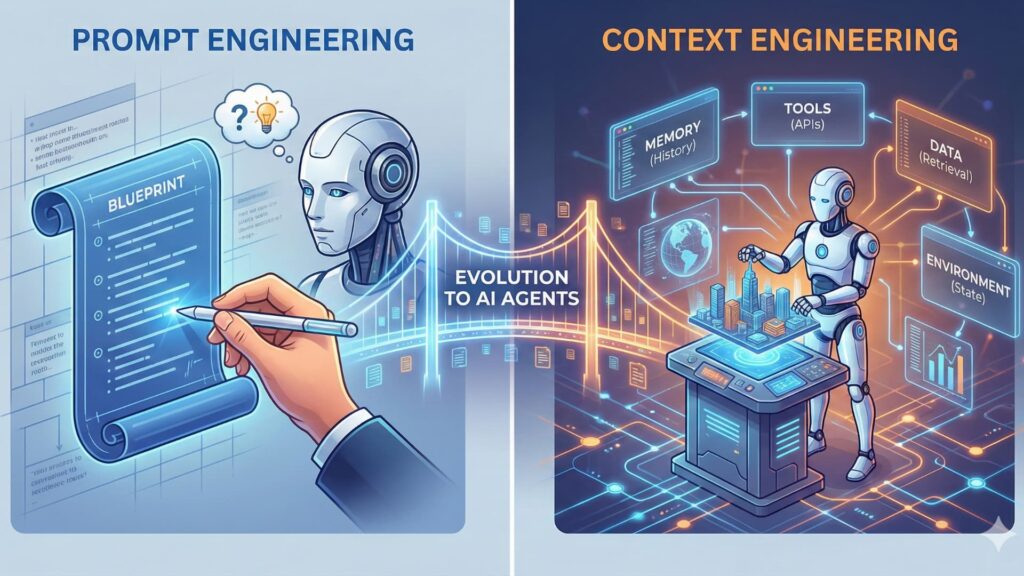

しかし、単に質問に答えるチャットボットから、自律的にタスクを遂行する「AIエージェント」へとその役割が拡大するにつれ、従来のプロンプトエンジニアリングだけでは解決できない壁が立ちはだかっています。

そこで登場した新たな、そしてより包括的な概念が「コンテキストエンジニアリング」です。

本記事では、これからのAI開発、特にAIエージェント構築において鍵を握るコンテキストエンジニアリングについて、従来のプロンプトエンジニアリングとの違いを明確にしながら詳細に解説します。

目次

1. プロンプトエンジニアリングのおさらい

まず、比較の基準となる「プロンプトエンジニアリング」について、その本質と限界を再確認しましょう。

基本的な定義とアプローチ

プロンプトエンジニアリングとは、LLMに対して与える入力文(プロンプト)を人間が工夫し、AIからの出力の質や方向性を制御する技術のことです。

LLMは非常に優秀ですが、曖昧な指示では意図しない回答をすることがあります。そこで、人間が「AIが理解しやすい命令文」を設計する必要があります。主なアプローチには以下のようなものがあります。

-

役割の付与(Role Prompting): 「あなたは熟練のマーケターです」と定義し、回答の視点を固定する。

-

例示(Few-shot Prompting): 望ましい入力と出力のペアをいくつか例示し、回答の形式を学ばせる。

-

思考の連鎖(Chain-of-Thought): 「ステップバイステップで考えてください」と指示し、論理的な推論過程を引き出す。

これらは、いわば優秀だが少し気の利かないアシスタントに対して、誤解のないように丁寧に指示書を書く作業(話術)と言えます。

なぜこれだけでは不十分なのか?(AIエージェントの視点)

プロンプトエンジニアリングは、一問一答形式のタスクでは非常に有効です。しかし、AIエージェントのように「長期的な記憶を保持し、外部ツールを使いながら、複数のステップにわたって自律的に目標を達成する」システムにおいては限界を迎えます。

最大の課題は、LLMが一度に処理できる情報量(コンテキストウィンドウ)には限りがある点です。過去の全ての会話履歴、膨大な外部データ、ツールの実行結果などを全て一つのテキストプロンプトに詰め込もうとすれば、すぐに容量オーバーになるか、AIが重要でない情報に惑わされてパフォーマンスが低下してしまいます。

「今、この瞬間の指示」を最適化するだけでは、複雑な世界で動くエージェントを制御しきれないのです。

関連記事:【総まとめ】AIエージェントとは?仕組み・種類・活用事例までを徹底解説

2. コンテキストエンジニアリングとは何か?

一方、コンテキストエンジニアリングは、より広範で動的な視点に立ち、LLMの能力を最大限に引き出すための環境を設計する技術です。

静的な「指示」から、動的な「環境構築」へ

定義するならば、コンテキストエンジニアリングとは、LLMが推論や応答を行う際に参照すべきあらゆる情報──プロンプトだけでなく、外部データ、検索結果、長期記憶、過去の行動履歴など──を、動的かつ構造的に組み立て、最適な状態でお膳立てする技術です。

LLMを「優秀な頭脳(シェフ)」だとすれば、プロンプトエンジニアリングは「完璧なレシピを渡すこと」です。

対して、コンテキストエンジニアリングは「最高の料理を作れるよう、調理場全体の環境を整えること」に相当します。必要な食材(データ)を冷蔵庫から出し、適切な調理器具(外部ツール)を手の届く場所に配置し、過去のオーダー履歴(記憶)を参照できるように準備するシステム全体の設計です。

構成する4つの重要な要素

コンテキストエンジニアリングは、主に以下の要素を動的に組み合わせることで実現します。

1.動的な外部知識(RAGなど):

LLMの学習データに含まれていない最新情報や社内データを、ベクトルデータベースなどから検索(Retrieval)し、必要な部分だけを抽出してコンテキストに加えます。

2.長期記憶と状態管理:

過去の会話履歴の要約や、ユーザーの嗜好、現在のタスクの進捗状況などを「記憶」として保持し、必要に応じて呼び出します。

3.ツールとAPIの連携結果:

「現在の天気を確認する」「カレンダーに予定を入れる」といった外部ツールの実行結果をリアルタイムで取得し、次の行動の判断材料としてLLMに渡します。

4.構造化された最終プロンプト:

上記1〜3で集められた雑多な情報を、そのままLLMに投げるのではなく、LLMが理解しやすい形式(JSON形式や明確なセクション分けなど)に整理・構造化して渡します。

3. 決定的な違い:比較まとめ

両者の違いを、いくつかの側面から整理して比較してみましょう。

| 比較項目 | プロンプトエンジニアリング | コンテキストエンジニアリング |

| アナロジー | 巧みな「話術」・指示出し | 最適な「作業環境」の設計・建築 |

| 焦点 | 人間が入力する「テキスト」の最適化 | LLMを取り巻く「情報環境全体」の最適化 |

| 時間軸 | 静的・瞬間的(その場のやり取り) | 動的・継続的(過去の記憶や未来の行動を含む) |

| 扱う情報 | ユーザーが直接入力したテキストが中心 | 会話履歴、長期記憶、外部検索結果、ツール実行結果など多岐にわたる |

| 目的 | より良い「回答」を引き出す | より良い「推論と行動」を支援する |

| AIエージェントにおける役割 | エージェントへの直接命令 | エージェントの脳が働くためのOS(基盤システム) |

4. 具体例で見るAIエージェントの動作

「ユーザーの好みを考慮して旅行プランを提案・予約するAIエージェント」を例に、両者のアプローチの違いを具体的に見てみましょう。

プロンプトエンジニアリングのみのアプローチ

ユーザーまたは開発者が、全ての情報を一つの巨大なプロンプトにまとめようとします。

「あなたは旅行代理店です。予算10万円、沖縄、静かな場所という条件で、来月の週末のフライトとホテルを提案してください。ただし、以前の会話で私が『海鮮が苦手』『高層階が好き』と言ったことを考慮し、現在の空き状況も踏まえて…(以下、延々と続く)」

これではプロンプトが長大になりすぎ、LLMは重要な条件を見落としたり、混乱したりする可能性が高まります。また、最新の空き状況をリアルタイムで反映させることも困難です。

コンテキストエンジニアリングのアプローチ

システムは、LLMにプロンプトを渡す前に、動的に情報を収集・構造化するプロセスを実行します。

-

記憶の検索: データベースから「ユーザーの嗜好(海鮮苦手、高層階好き)」を引き出す。

-

ツールの使用: 旅行予約サイトのAPIを叩き、「来月の沖縄の空き状況と価格」を取得する。

-

コンテキストの構築: 上記の情報を整理し、以下のような構造化されたデータをLLMに渡す。

# 現在のコンテキスト状況

- ユーザーの要望: 予算10万円、沖縄、静かな場所

- ユーザーの記憶: 海鮮苦手、高層階希望

- 外部情報(検索結果):

- フライトA: 残席わずか、往復4万円

- ホテルB: 静かなエリア、高層階空きあり、一泊3万円

LLMは、完璧にお膳立てされたこのコンテキストを受け取るため、「これらの条件に最も合うプランを提案して」という単純な指示だけで、非常に精度の高い回答を生成できます。

まとめ:プロンプトのその先へ

AIエージェントが真に役立つ存在となるためには、「今何を聞かれたか」だけでなく、「これまで何をしてきたか」「自分は何を知っているか」「今どんな道具が使えるか」といった動的な文脈(コンテキスト)を常に正しく把握し続ける必要があります。

プロンプトエンジニアリングが不要になるわけではありません。コンテキストエンジニアリングという強固な土台の上で、最終的にLLMを動かすトリガーとなるのは、やはり優れたプロンプトだからです。

しかし、AI開発の主戦場は、いかに巧みな言葉を選ぶかという「話術」から、いかにLLMが能力を発揮しやすい情報環境を設計するかという「建築術」へとシフトしています。この「コンテキストをエンジニアリングする力」こそが、今後のAI活用において最も重要なスキルとなるでしょう。